כשהתחלתי את דרכי בעולם ה-SEO לפני כ-5 שנים, אחד הדברים הראשונים שלמדתי היה על חשיבותו של קובץ robots.txt. קובץ זה, למרות פשטותו, הוא כלי רב-עוצמה בארסנל של כל מקדם אתרים ובעל אתר. אז מהו בדיוק robots.txt?

robots.txt הוא קובץ טקסט פשוט הממוקם בתיקיית השורש של האתר שלכם. תפקידו העיקרי הוא לספק הנחיות לזחלנים (או "רובוטים") של מנועי החיפוש לגבי אילו חלקים באתר הם רשאים לסרוק ואילו לא. חשבו עליו כמעין "שלט הכוונה" דיגיטלי עבור מנועי החיפוש.

חשיבותו של קובץ robots.txt

- שליטה בסריקת האתר: הוא מאפשר לכם לכוון את מנועי החיפוש לחלקים החשובים ביותר באתר שלכם.

- אופטימיזציה של משאבי שרת: על ידי מניעת סריקה של דפים לא חיוניים, אתם חוסכים במשאבי שרת.

- שיפור ביצועי SEO: הכוונת הזחלנים לתוכן הרלוונטי ביותר יכולה לשפר את הדירוג שלכם בתוצאות החיפוש.

- הגנה על תוכן רגיש: ניתן להשתמש בו כדי למנוע אינדוקס של אזורים פרטיים או רגישים באתר.

לאורך השנים, השימוש ב-robots.txt התפתח והשתכלל. מה שהחל כפתרון פשוט למניעת עומס על שרתים, הפך לכלי מתוחכם המשפיע על אסטרטגיית ה-SEO הכוללת של האתר. היום, הבנה מעמיקה של robots.txt היא חיונית לכל מי שרוצה להצליח בעולם הדיגיטלי התחרותי.

במאמר זה, אשתף איתכם את הידע והניסיון שצברתי במשך שנים של עבודה עם קבצי robots.txt. נצלול לעומק ההגדרות, נבחן דוגמאות מעשיות, ונלמד כיצד להשתמש בכלי זה באופן אופטימלי כדי לשפר את הנוכחות המקוונת שלכם.

מיקום ומבנה בסיסי של קובץ robots.txt

לאחר שהבנו את חשיבותו של קובץ robots.txt, בואו נצלול לפרטים הטכניים. המיקום הנכון של הקובץ הוא קריטי להצלחתו. זכרו, אם הקובץ לא נמצא במקום הנכון, מנועי החיפוש פשוט יתעלמו ממנו, ויסרקו את האתר שלכם ללא הגבלות.

הנה הכללים החשובים ביותר למיקום קובץ robots.txt:

- הקובץ חייב להיות בתיקיית השורש (root directory) של האתר שלכם.

- הכתובת המלאה של הקובץ צריכה להיות בפורמט: https://www.example.com/robots.txt

- שם הקובץ חייב להיות בדיוק "robots.txt", באותיות קטנות.

- הקובץ חייב להיות בפורמט טקסט רגיל (plain text).

עכשיו, בואו נדבר על המבנה הבסיסי של הקובץ. קובץ robots.txt מורכב משני חלקים עיקריים: User-agent ו-Disallow (או Allow). הנה דוגמה בסיסית:

User-agent: *

Disallow: /private/

Allow: /public/

בואו נפרק את הדוגמה הזו:

- User-agent: * – זה אומר שההוראות חלות על כל הרובוטים. הכוכבית (*) היא תו כללי המייצג את כל סוגי הזחלנים.

- Disallow: /private/ – זה מורה לרובוטים לא לסרוק את התיקייה "/private/" וכל תת-התיקיות שלה.

- Allow: /public/ – זה מאפשר במפורש לרובוטים לסרוק את התיקייה "/public/" וכל תת-התיקיות שלה.

חשוב לציין שההוראות נקראות מלמעלה למטה, וההוראה הספציפית ביותר גוברת. למשל, אם יש לכם:

User-agent: *

Disallow: /folder1/

Allow: /folder1/specific-page.html

זה יחסום את כל התוכן ב-"/folder1/", אבל יאפשר גישה ספציפית ל-"specific-page.html" בתוך אותה תיקייה.

זכרו, השימוש ב-robots.txt הוא עניין של איזון עדין. מצד אחד, אתם רוצים לוודא שמנועי החיפוש מגיעים לכל התוכן החשוב שלכם. מצד שני, אתם רוצים למנוע מהם לבזבז זמן על תוכן לא רלוונטי או פרטי. בפרקים הבאים, נלמד על שימושים מתקדמים יותר שיעזרו לכם למצוא את האיזון המושלם עבור האתר שלכם.

הנחיות מתקדמות וסינטקס מורכב בקובץ robots.txt

לאחר שהבנו את היסודות, הגיע הזמן לצלול לעומק ולחקור את ההנחיות המתקדמות והסינטקס המורכב יותר של קובץ robots.txt. מניסיוני, הבנה מעמיקה של אפשרויות אלו יכולה להעניק יתרון משמעותי בניהול יעיל של האתר ובשיפור ה-SEO.

בואו נתחיל עם ההנחיות המתקדמות:

- Allow: משמשת לציון מפורש של URL או תיקיות שמותר לסרוק, גם אם הן נמצאות בתוך תיקייה שנאסרה לסריקה.

- Sitemap: מציינת את המיקום של מפת האתר, עוזרת למנועי חיפוש למצוא את כל הדפים החשובים באתר.

- Crawl-delay: מגדירה את מספר השניות שעל הרובוט להמתין בין בקשות עוקבות. שימושי למניעת עומס על השרת.

דוגמה לשימוש בהנחיות אלו:

User-agent: * Disallow: /private/ Allow: /private/public-file.html Crawl-delay: 10 Sitemap: https://www.example.com/sitemap.xml עכשיו, בואו נדבר על סינטקס מורכב יותר, כולל שימוש ב-wildcards:

- * (כוכבית): מייצגת כל רצף של תווים.

- $ (סימן דולר): מציין את סוף ה-URL.

הנה כמה דוגמאות לשימוש ב-wildcards:

User-agent: * Disallow: /*.pdf$ Disallow: /*?* Allow: /*/public במקרה זה:

/*.pdf$חוסם גישה לכל קובץ PDF באתר./*?*חוסם גישה לכל URL המכיל סימן שאלה (לרוב דפי חיפוש או פרמטרים דינמיים)./*/publicמאפשר גישה לכל תיקייה בשם "public", לא משנה איפה היא נמצאת במבנה האתר.

חשוב לזכור שסינטקס מורכב דורש זהירות. שגיאה קטנה יכולה לגרום לחסימה לא מכוונת של תוכן חשוב או לחשיפה של תוכן שהתכוונתם להסתיר. לכן, תמיד בדקו את הקובץ שלכם באמצעות כלי בדיקה (עליהם נדבר בהמשך) לפני העלאתו לשרת.

שימוש מושכל בהנחיות מתקדמות ובסינטקס מורכב יכול לעזור לכם:

- למנוע כפילות תוכן על ידי חסימת גרסאות מיותרות של דפים.

- לשפר את יעילות הסריקה על ידי הכוונת זחלנים לתוכן החשוב ביותר.

- להגן על מידע רגיש או פרטי מפני אינדוקס לא רצוי.

- לנהל ביעילות אתרים גדולים ומורכבים עם מבנה תיקיות מסועף.

בפרק הבא, נבחן כיצד קובץ robots.txt משפיע על ביצועי האתר וזמני הטעינה, ונלמד כיצד לאזן בין הגבלת הגישה לבין אופטימיזציה לסריקה יעילה.

השפעת robots.txt על ביצועי האתר וזמני טעינה

קובץ robots.txt אינו רק כלי להכוונת זחלנים, אלא, כפי שכבר ציינתי, הוא יכול גם להשפיע באופן דרמטי על ביצועי האתר. מדובר במרכיב מפתח באופטימיזציית האתר.

כיצד robots.txt משפיע על ביצועי האתר?

- הפחתת עומס על השרת: על ידי חסימת זחלנים מסריקת דפים לא נחוצים, אתם מפחיתים את מספר הבקשות לשרת.

- שיפור זמני טעינה: פחות סריקות משמעותן פחות משאבים מוקדשים לטיפול בבקשות של זחלנים, מה שמשפר את זמני התגובה עבור משתמשים אנושיים.

- אופטימיזציה של תקציב הסריקה: הכוונת זחלנים לתוכן החשוב ביותר מבטיחה ניצול יעיל של תקציב הסריקה של מנועי החיפוש.

- מניעת אינדוקס של תוכן כפול: חסימת גרסאות כפולות של דפים חוסכת משאבי שרת ומשפרת את איכות האינדקס.

בואו נבחן דוגמה מספרית להמחשת ההשפעה:

לפני אופטימיזציה

10,000 דפים נסרקים מדי יום

זמן טעינה ממוצע: 3 שניותעומס שרת: 70%אחרי אופטימיזציה

5,000 דפים נסרקים מדי יום (רק התוכן הרלוונטי)

זמן טעינה ממוצע: 1.8 שניות

עומס שרת: 45%

כדי לאזן בין הגבלת גישה לבין סריקה יעילה, הנה כמה טיפים מניסיוני:

- שימוש חכם ב-Crawl-delay: עבור אתרים גדולים, הגדרת Crawl-delay של 5-10 שניות יכולה לעזור לאזן את העומס.

- חסימה סלקטיבית: חסמו רק את התוכן שבאמת לא צריך להיות מאונדקס, כמו דפי ניהול או גרסאות טיוטה.

- שימוש ב-Sitemap: ציינו את מיקום ה-Sitemap שלכם בקובץ robots.txt כדי לעזור לזחלנים למצוא את התוכן החשוב ביותר בקלות.

- ניטור קבוע: בדקו באופן שוטף את דוחות הסריקה ב-Google Search Console כדי לזהות בעיות ולאופטימיזציה נוספת.

חשוב לציין שהשפעת ה-robots.txt על ביצועים משתנה בהתאם לגודל האתר ולתדירות העדכונים. אתר חדשות גדול, למשל, ידרוש גישה שונה מאשר אתר תדמית קטן. הנה כמה המלצות ספציפיות:

- אתרים גדולים (מעל 10,000 דפים): השתמשו ב-Crawl-delay בזהירות והתמקדו בחסימת אזורים לא חיוניים כמו דפי חיפוש פנימיים.

- אתרי ecommerce: חסמו דפי סינון ומיון מיותרים, אך ודאו שדפי מוצרים ראשיים נגישים.

- אתרי תוכן: אפשרו גישה לכל התוכן העיקרי, אך שקלו לחסום תגיות וארכיונים ישנים אם הם יוצרים עומס רב.

לסיכום, אופטימיזציה נכונה של קובץ robots.txt היא מפתח לשיפור ביצועי האתר. היא מאפשרת לכם לנווט בין הצורך בנראות מקסימלית במנועי חיפוש לבין שמירה על חווית משתמש מהירה ויעילה. בפרק הבא, נבחן דוגמאות ספציפיות לקובץ robots.txt באתרי וורדפרס ונראה כיצד ליישם את העקרונות הללו בפלטפורמה הפופולרית הזו.

דוגמאות לקובץ robots.txt באתרי וורדפרס

וורדפרס, כפלטפורמת האתרים המובילה בעולם, דורשת התייחסות מיוחדת כשמדובר בקובץ robots.txt. מניסיוני בעבודה עם מאות אתרי וורדפרס, גיליתי שקונפיגורציה נכונה של קובץ זה יכולה להוביל לשיפור משמעותי בביצועי SEO. הנה דוגמה מקיפה לקובץ robots.txt עבור אתר וורדפרס טיפוסי:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Disallow: /wp-includes/ Disallow: /wp-content/plugins/ Disallow: /wp-content/themes/ Disallow: */trackback/ Disallow: */feed/ Disallow: /cgi-bin/ Disallow: /tmp/ Allow: /wp-content/uploads/ Disallow: /search/ Disallow: /?s= Disallow: /page/*/?s= Disallow: /author/ Sitemap: https://www.yourdomain.com/sitemap_index.xml בואו נפרק את הקובץ הזה ונסביר כל חלק:

- חסימת אזור הניהול:

Disallow: /wp-admin/מונע גישה לאזור הניהול, אךAllow: /wp-admin/admin-ajax.phpמאפשר פונקציונליות AJAX חיונית. - הגנה על קבצי מערכת:חסימת הגישה ל-/wp-includes/, /wp-content/plugins/, ו-/wp-content/themes/ מגנה על קבצי מערכת רגישים.

- מניעת כפילות תוכן:חסימת */trackback/ ו-*/feed/ עוזרת למנוע אינדוקס של גרסאות כפולות של תוכן.

- גישה לתמונות וקבצי מדיה:

Allow: /wp-content/uploads/מבטיח שתמונות וקבצי מדיה יהיו נגישים לסריקה ואינדוקס. - מניעת דפי חיפוש פנימיים:חסימת /search/, /?s=, ו-/page/*/?s= מונעת אינדוקס של דפי חיפוש פנימיים, שעלולים ליצור תוכן כפול.

- טיפול בדפי מחברים:

Disallow: /author/מונע אינדוקס של דפי מחברים, שלעיתים קרובות אינם מספקים ערך למשתמשים. - הצהרת Sitemap:הכללת הצהרת Sitemap עוזרת למנועי חיפוש למצוא את מפת האתר שלכם ולסרוק את האתר ביעילות.

חשוב לזכור שקונפיגורציה זו היא נקודת התחלה מצוינת, אך ייתכן שתצטרכו להתאים אותה לצרכים הספציפיים של האתר שלכם. למשל:

- אתרי מסחר אלקטרוני בוורדפרס: ייתכן שתרצו להוסיף

Disallow: /cart/ו-Disallow: /checkout/כדי למנוע אינדוקס של דפי עגלת קניות ותשלום. - אתרי חדשות או בלוגים גדולים: שקלו להוסיף

Disallow: /tag/אם דפי התגיות שלכם אינם מספקים ערך ייחודי. - אתרים רב-לשוניים: אם אתם משתמשים בתוסף כמו WPML, ייתכן שתרצו לחסום גרסאות שפה ספציפיות, למשל

Disallow: /fr/לגרסה הצרפתית.

זכרו, השימוש בקובץ robots.txt צריך להיות חלק מאסטרטגיית SEO כוללת. שילוב נכון עם תגיות meta robots, קנוניקליזציה נכונה, ומבנה אתר מאורגן היטב יכול להוביל לשיפור משמעותי בדירוג האתר שלכם.

בפרק הבא, נדון בשגיאות נפוצות בשימוש ב-robots.txt באתרי וורדפרס וכיצד להימנע מהן, כדי להבטיח שהאתר שלכם מקבל את החשיפה המקסימלית במנועי החיפוש תוך שמירה על אבטחה ויעילות.

שגיאות נפוצות וכיצד להימנע מהן

בשנים האחרונות נתקלתי במגוון רחב של שגיאות בקבצי robots.txt – לרוב אצל אתרי לקוחות שלי שעברו קידום לפני כן באי אלו חברות וסוכנויות קידום – חלקן תמימות, אולם אחרות הרסניות לחלוטין לביצועי האתר. הבנת השגיאות הנפוצות ודרכי המניעה שלהן היא קריטית לניהול יעיל של האתר שלכם. הנה הרשימה המקיפה של השגיאות הנפוצות ביותר והדרכים להימנע מהן:

חסימת יתר

זוהי אולי השגיאה המסוכנת ביותר. חסימה של יותר מדי תוכן יכולה לגרום לנפילה דרמטית בדירוג האתר.

דוגמה לשגיאה: User-agent: * Disallow: /

תיקון: הגדירו בקפידה אילו חלקים באתר צריכים להיחסם. למשל: Disallow: /private/

שימוש לא נכון בתחביר

שגיאות תחביר יכולות לגרום למנועי חיפוש להתעלם מההוראות או לפרש אותן באופן שגוי.

דוגמה לשגיאה: dissallow: /admin/ (כתיב שגוי)

תיקון: הקפידו על כתיב נכון: Disallow: /admin/

אי-שימוש ב-wildcards

אי-שימוש ב-wildcards יכול להוביל לחסימה לא יעילה או חלקית של תוכן.

דוגמה לשגיאה: Disallow: /page1 Disallow: /page2 Disallow: /page3

תיקון: השתמשו ב-wildcard: Disallow: /page*

חסימת משאבים חשובים

חסימת קבצי CSS, JavaScript או תמונות יכולה לפגוע בהבנה של מנועי החיפוש את האתר שלכם.

דוגמה לשגיאה: Disallow: /wp-content/

תיקון: אפשרו גישה לקבצים חיוניים: Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/

אי-התאמה בין robots.txt לתגיות Meta Robots

סתירות בין robots.txt לבין תגיות Meta Robots יכולות לגרום לבלבול ולהתנהגות לא צפויה של מנועי חיפוש.

דוגמה לשגיאה: חסימת דף ב-robots.txt אך שימוש בתגית index ב-Meta Robots

תיקון: ודאו עקביות בין robots.txt לתגיות Meta Robots. העדיפו שימוש בתגיות Meta Robots לשליטה ברמת הדף

איך להימנע משגיאות אלו?

- בדיקה קבועה: בדקו את קובץ robots.txt שלכם לפחות פעם בחודש, במיוחד לאחר עדכונים משמעותיים לאתר.

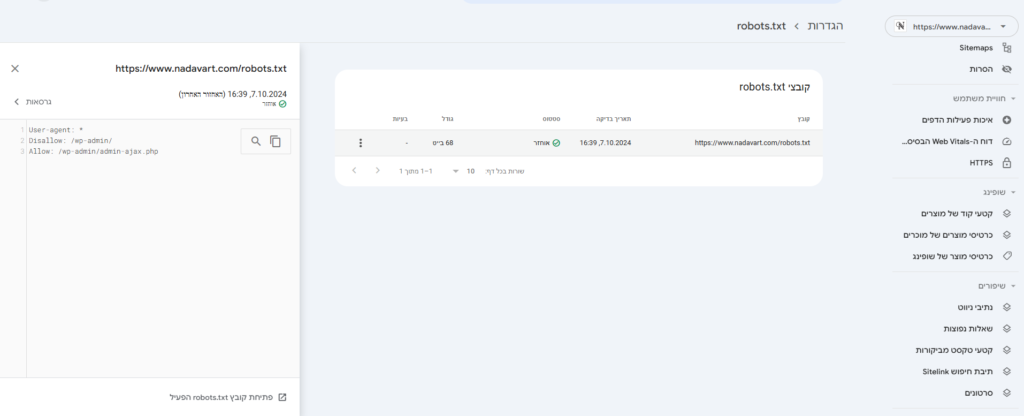

- שימוש בכלי בדיקה: השתמשו בכלים כמו Google Search Console לבדיקת קובץ robots.txt שלכם.

- גיבוי: שמרו תמיד עותק של הקובץ הקודם לפני ביצוע שינויים.

- ניטור תנועה: עקבו אחר שינויים בתנועה האורגנית לאחר עדכון הקובץ.

- התייעצות עם מומחים: אם אתם לא בטוחים, התייעצו עם מומחה SEO לפני ביצוע שינויים משמעותיים.

זכרו, קובץ robots.txt הוא כלי רב-עוצמה, אך גם עדין. שימוש נכון בו יכול לשפר משמעותית את ביצועי ה-SEO שלכם, בעוד ששגיאות יכולות להוביל לנזק משמעותי. בפרק הבא, נסקור כלים מתקדמים לבדיקה ואימות של קובץ robots.txt, שיעזרו לכם להבטיח שהקובץ שלכם פועל בדיוק כפי שאתם מצפים.

כלים מתקדמים לבדיקה ואימות של קובץ robots.txt

לאורך השנים, פיתחתי הערכה עמוקה לחשיבות של בדיקה ואימות קפדניים של קובץ robots.txt. כלים מתקדמים לא רק מסייעים במניעת שגיאות, אלא גם מספקים תובנות מעמיקות לגבי האופן שבו מנועי חיפוש מפרשים את ההוראות שלכם. הנה סקירה מקיפה של הכלים החיוניים ביותר:

Google Search Console

זהו הכלי הרשמי של גוגל לבדיקת קובץ robots.txt.

יתרונות: דיוק גבוה, משקף את הפרשנות של גוגל

שימוש: העלו את הקובץ או העתיקו את תוכנו, ובדקו URL ספציפיים

טיפ: השתמשו בו לבדיקת URL חשובים כדי לוודא שהם לא נחסמים בטעות

Screaming Frog

כלי רב-עוצמה לניתוח אתרים, כולל בדיקת robots.txt.

יתרונות: מאפשר סימולציה של סריקת אתר עם הגדרות robots.txt שונות

שימוש: הפעילו סריקה ובחנו את הדוח "Robots.txt" לזיהוי בעיות

טיפ: השוו תוצאות סריקה עם וללא הגבלות robots.txt להבנת ההשפעה

SEOQuake – תוסף דפדפן

תוסף שימושי המספק מידע מהיר על robots.txt.

יתרונות: נוח לשימוש, מספק מידע מיידי בעת גלישה

שימוש: התקינו את התוסף וצפו במידע על robots.txt בכל אתר

טיפ: שימושי במיוחד לבדיקה מהירה של אתרים מתחרים

Robots.txt Validator and Testing Tool

כלי מקוון חינמי לבדיקת תקינות הקובץ.

יתרונות: קל לשימוש, מספק הסברים מפורטים על שגיאות

שימוש: הדביקו את תוכן הקובץ או הזינו את כתובת האתר

טיפ: מצוין לזיהוי שגיאות תחביר ובעיות לוגיות בקובץ

Ryte Website Success

פלטפורמה מקיפה לניתוח אתרים, כולל בדיקת robots.txt.

יתרונות: מספק ניתוח מעמיק ומציע שיפורים

שימוש: הוסיפו את האתר שלכם ובחנו את הדוח המפורט

טיפ: שימו לב להמלצות האוטומטיות לשיפור הקובץ

באופן אישי, אני משלב את השימוש בכלים אלה באופן הבא:

- בדיקה שבועית: אני משתמש ב-Google Search Console לבדיקה שגרתית.

- בדיקה חודשית מעמיקה: אני מבצע סריקה מלאה עם Screaming Frog לזיהוי בעיות מורכבות יותר.

- לפני שינויים גדולים: אני מריץ בדיקות ב-Robots.txt Validator לוודא שאין שגיאות תחביר.

- ניטור מתמשך: אני משתמש ב-SEOQuake לבדיקות מהירות בזמן גלישה באתר.

- ניתוח רבעוני: אני מבצע ניתוח מעמיק עם Ryte לקבלת תובנות ארוכות טווח.

זכרו, השימוש בכלים אלה הוא חיוני, אך לא מספיק. חשוב להבין את התוצאות ולפעול בהתאם. בפרק הבא, נדון במגבלות של קובץ robots.txt ובחלופות מתקדמות, כדי לתת לכם תמונה מלאה של כיצד לנהל את הגישה של מנועי חיפוש לאתר שלכם.

מגבלות של קובץ robots.txt וחלופות מתקדמות

פעמים רבות, במיוחד לאחרונה, נתקלתי בתפיסה מוטעית לגבי יכולותיו של קובץ robots.txt. שהרי, למרות חשיבותו הרבה, חשוב להבין את מגבלותיו ולהכיר חלופות מתקדמות. הבנה זו מאפשרת לנו לנהל את הנראות של האתר במנועי חיפוש בצורה יעילה ומדויקת יותר.

מגבלות עיקריות של robots.txt

- אינו מבטיח חסימה מוחלטת: זחלנים עשויים להתעלם מההוראות.

- לא מונע אינדוקס: דפים יכולים להופיע בתוצאות חיפוש גם אם הם חסומים.

- מוגבל בשליטה ברמת הדף: קשה לשלוט בדפים ספציפיים בלי להשפיע על תיקיות שלמות.

- לא מספק הגנת אבטחה: אינו מונע גישה למשתמשים או האקרים.

טכניקות משלימות מומלצות

תגיות Meta Robots

מאפשרות שליטה מדויקת ברמת הדף הבודד.

יתרון: שליטה מדויקת יותר מאשר robots.txt

שימוש: הוסיפו <meta name="robots" content="noindex, nofollow"> לדפים ספציפיים

X-Robots-Tag HTTP Headers

מאפשר שליטה בקבצים שאינם HTML, כמו PDF או תמונות.

יתרון: יעיל לקבצים מרובים או דינמיים

שימוש: הגדירו ב-htaccess או בקונפיגורציית השרת

הגנה באמצעות סיסמה

מספקת שכבת אבטחה נוספת לתוכן רגיש.

יתרון: מונע גישה הן מזחלנים והן ממשתמשים לא מורשים

שימוש: הגדירו אזורים מוגנים בסיסמה בשרת

קנוניקליזציה

עוזרת במניעת בעיות תוכן כפול בלי לחסום גישה.

יתרון: מאפשר לזחלנים לראות את התוכן אך מכווין את "הקרדיט" לדף הרצוי

שימוש: הוסיפו תגיות <link rel="canonical" href="URL">

שימוש ב-Noindex,Follow

מאפשר לזחלנים לעקוב אחר קישורים בדף מבלי לאנדקס אותו.

יתרון: שומר על זרימת ה-PageRank תוך מניעת הופעה בתוצאות חיפוש

שימוש: הוסיפו <meta name="robots" content="noindex,follow">

בפרויקטים שלי, אני משלב בין robots.txt לבין טכניקות אלו באופן הבא:

- robots.txt: לחסימה רחבה של תיקיות שלמות (כמו /wp-admin/)

- Meta Robots: לשליטה מדויקת בדפים בודדים

- X-Robots-Tag: לטיפול בקבצי מדיה ומסמכים

- קנוניקליזציה: למניעת בעיות תוכן כפול בדפים דינמיים

- הגנת סיסמה: לאזורים רגישים במיוחד באתר

מגמות עתידיות ושינויים צפויים בשימוש ב-robots.txt

כמי שעוקב אחר התפתחויות בתחום ה-SEO כבר שנים רבות, אני תמיד מתרגש לחשוב על העתיד. בכל הנוגע ל-robots.txt, אנו עומדים בפני כמה שינויים מרתקים שעשויים לשנות את האופן בו אנו מנהלים את הנגישות של אתרינו למנועי חיפוש. הנה כמה מהמגמות העיקריות שאני צופה:

- אינטגרציה עם בינה מלאכותית (AI):מנועי חיפוש הופכים חכמים יותר בפענוח כוונות של בעלי אתרים.

- השפעה: פרשנות מדויקת יותר של הוראות robots.txt מורכבות

- המלצה: התכוננו לשימוש בשפה טבעית יותר בהגדרות robots.txt

- הרחבת פרוטוקול Robots Exclusion:גוגל מובילה מאמצים לסטנדרטיזציה של הפרוטוקול.

- השפעה: תמיכה רחבה יותר בהוראות מתקדמות בין מנועי חיפוש שונים

- המלצה: עקבו אחר עדכונים רשמיים והתאימו את הקבצים שלכם בהתאם

- אופטימיזציה דינמית:כלים אוטומטיים לעדכון robots.txt בזמן אמת בהתאם לביצועי האתר.

- השפעה: התאמה מהירה יותר לשינויים בתנועה ובדפוסי גלישה

- המלצה: שקלו אימוץ כלים המציעים עדכונים אוטומטיים, תוך שמירה על פיקוח אנושי

- אינטגרציה עם פרוטוקולי אבטחה:שילוב הדוק יותר בין robots.txt להגדרות אבטחה של האתר.

- השפעה: שליטה מדויקת יותר בגישה לחלקים רגישים של האתר

- המלצה: למדו כיצד לשלב הגדרות robots.txt עם מערכות האבטחה שלכם

- התאמה למובייל וחוויות מותאמות אישית:הוראות ספציפיות לסוגי מכשירים וקהלי יעד שונים.

- השפעה: יכולת לכוון תוכן ספציפי לפלטפורמות וקהלים שונים

- המלצה: התחילו לחשוב על אסטרטגיות robots.txt נפרדות למובייל ודסקטופ

קובץ robots.txt: סיכום ומסקנות

לאחר שצללנו לעומקו של עולם ה-robots.txt, ברור לי יותר מתמיד כמה קריטי הוא להצלחת האתר שלכם. כמקדם אתרים, אני יכול להעיד שהבנה מעמיקה ושימוש נכון בקובץ זה יכולים להוות את ההבדל בין אתר שמשגשג לבין אתר שנאבק להתבלט. הנה המסקנות העיקריות שלי:

- יסוד חיוני ל-SEO: קובץ robots.txt הוא הרבה יותר מסתם קובץ טקסט; הוא כלי אסטרטגי בארסנל ה-SEO שלכם.

- איזון עדין: השימוש ב-robots.txt דורש איזון בין נגישות לשליטה, בין חשיפה להגנה על תוכן.

- התפתחות מתמדת: ככל שהטכנולוגיה מתקדמת, כך גם האופן שבו אנו משתמשים ומפרשים robots.txt.

- מעבר לחסימה פשוטה: robots.txt הוא כלי לניהול משאבים, אופטימיזציה של ביצועים, והכוונת מנועי חיפוש.

- חלק ממכלול: יש לראות את robots.txt כחלק מאסטרטגיית SEO כוללת, לצד כלים וטכניקות אחרות.

המלצות אחרונות לניהול ותחזוקה אפקטיביים של הקובץ:

- בדיקות תקופתיות: בצעו סקירה חודשית של הקובץ שלכם לוודא שהוא עדיין תואם את צרכי האתר.

- עקבו אחר שינויים: נהלו גרסאות של הקובץ ותעדו כל שינוי והשפעתו.

- שימוש בכלים מתקדמים: נצלו את הכלים שסקרנו כדי לבדוק ולאמת את הקובץ באופן קבוע.

- התאמה אישית: התאימו את ההגדרות לצרכים הספציפיים של האתר שלכם; אין פתרון אחד שמתאים לכולם.

- שילוב טכניקות: שלבו את השימוש ב-robots.txt עם שיטות אחרות כמו meta robots ו-canonicalization.

לסיום, זכרו תמיד שהעולם הדיגיטלי הוא דינמי ומשתנה תדיר. מה שעובד היום עשוי להשתנות מחר. לכן, ההמלצה החשובה ביותר שלי היא להישאר סקרנים, להמשיך ללמוד, ולהתאים את האסטרטגיות שלכם בהתאם. robots.txt הוא כלי רב-עוצמה, אך כמו כל כלי, האפקטיביות שלו תלויה באופן שבו אתם משתמשים בו.

אני מקווה שמאמר זה סיפק לכם את הידע והכלים להפוך את קובץ ה-robots.txt שלכם מסתם קובץ טקסט לנכס אסטרטגי בקידום האתר שלכם. זכרו, ב-SEO, כמו בחיים, הפרטים הקטנים הם שעושים את ההבדל הגדול. נצלו את הכוח של robots.txt, והובילו את האתר שלכם לפסגת תוצאות החיפוש!